|

|

количество взаимной информации в случайных величинах

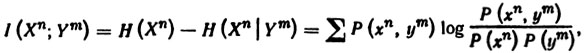

Мера уменьшения неопределенности случайной величины, возникающего вследствие того, что становится известным значение другой случайной величины, усредненного по знаниям последней; для дискретных случайных величин ее выражение имеет вид

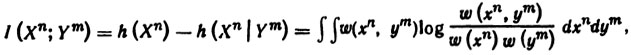

где суммирование ведется по всему множеству значений хn, уm случайных величин Xn, ym; для непрерывных случайных величин ее выражение имеет вид

где интегрирование ведется по всему множеству значений xn, уm случайных величин Хn, Уm.

Примечания

1. Вместо термина «количество взаимной информации в случайных величинах» иногда употребляют выражение «количество информации о случайной величине, содержащееся в другой случайной величине».

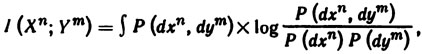

2. Общая форма математической записи выражения количества взаимной информации, справедливая в произвольном случае, имеет вид

где Р(хn, уm), Р(хn) и Р(уm) —вероятностные меры, заданные соответственно на множествах значений {хn, уm), хn и уm случайных величии (Xn, Уm), Хn и Уm.

[Сборник рекомендуемых терминов. Выпуск 94. Теория передачи информации. Академия наук СССР. Комитет технической терминологии. 1979 г.]

|

|

EN |

|

|

FR |

|

|

Тематики

- теория передачи информации

EN

- mutual information between two random variables

|